自然災害に対する防災対策には、リスク評価が欠かせない。これに役立つ情報基盤の確立を目指し、文部科学省は「気候変動リスク情報創生プログラム」を推進している。統数研チームは確率のプロとして参加し、より効率的な「気候変動がもたらす将来予測」に貢献している。

気象現象の発生確率を予測し災害のリスク評価につなげる

近年、記録的な猛暑や集中豪雨、竜巻や突風、厳寒や豪雪などの異常気象が頻発し、社会・経済に打撃を与えている。こうした被害を未然に防ぐためには、地球上のどの場所に、いつ、どのような気象現象が現れるかを、定量的に把握することが欠かせない。

自然災害に対し、防災や減災の対策に役立つこうした情報を創出するのが、2012年度から2016年度の5年にわたり文部科学省が主導する「気候変動リスク情報創生プログラム」だ。世界最高水準のスーパーコンピュータ「地球シミュレータ」を活用し、気象現象の発生確率を予測することで、災害のリスク評価につなげる。

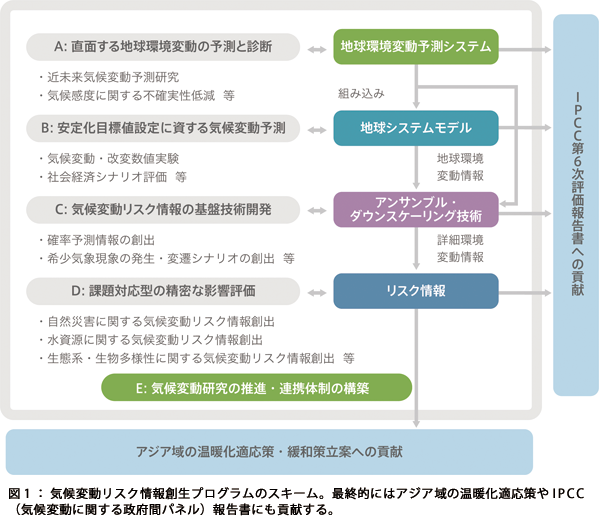

同プログラムは現在、A〜Dの領域で進められている(図1)。このうち、領域テーマCは、より詳細な予測情報の抽出や、巨大台風の上陸といったごく稀にしか起きない気象現象の想定シナリオ作成を目的とする。これは、自然災害への対策や適応策を講じるためのリスク予測や評価を手掛ける領域テーマDの基となる情報だ。

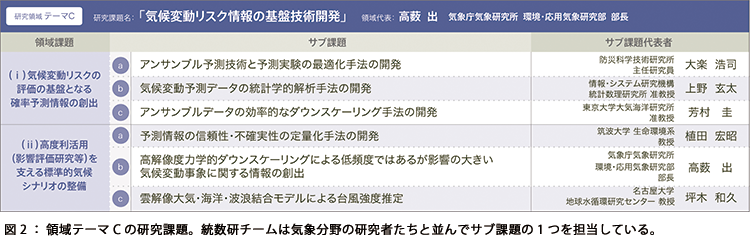

統数研が担当しているのは、領域テーマCのサブ課題「気候変動予測データの統計学的解析手法の開発」(図2)。メンバーは上野玄太准教授、中野慎也助教、鈴木香寿恵特任研究員、伊庭幸人教授の4人で、いずれもデータ同化研究開発センターに所属している。

リーダーの上野は「Dのリスク評価に活用するデータセットを作ることがミッションなので、利用者側と連携し、ニーズに沿うよう心がけています」と話す。

具体的な課題は、「高頻度事象の確率分布の創出」と「低頻度であるが影響の大きい事象の確率分布創出手法の開発」の2つ。高頻度事象とは平均気温や降水量など、一般に大規模シミュレーションでそのまま統計的予測が可能な事柄を意味する。これに対し、低頻度事象とは「台風が日本本土に来襲する」などそれほど頻繁には起こらないがリスクの高い事象を指す。前者は上野が中心となって伊庭がサポートし、後者は中野、鈴木、伊庭が担当している。

統計学的手法を駆使して効率的なシミュレーションを実施

高頻度事象について手掛けているのは、50年〜100年後の気候の予測だ。例えば、ある場所の気温がこれから上がるのか下がるのか、その年間の分布はどうなるのか、いろいろなシナリオの確率を求めたい。素材として、各国で開発された22種の「全球気候モデル(Global Climate Model, GCM)」で計算した1901年から2099年の200年分のデータが用意された。問題は、いかにこれを重みづけし、統合するか。そこに、確率のプロとしての統数研の知見が求められた。

当初、気象学を専門とする共同研究者は、「これまでの観測値の予測能力をもとにモデルを重みづけしてほしい」と統数研チームに要請。これに対し上野らは、重みをつけたうえでさらに複数のモデルの予測を統合する手法を提案して、先方を驚かせた。22種のモデルからどれとどれを採用するかの組み合わせは膨大な数となる。その中からベストなものを見つける計算時間は途方もないものになると思われたからだ。

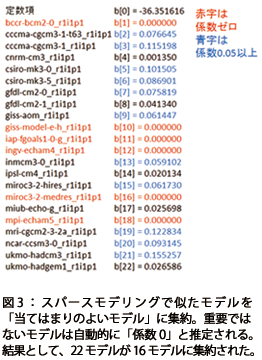

だが、もちろん上野らには考えがあった。「まず全体の中から『当てはまりのよいモデル』を見つけ、次にこれらと類似したモデルを除きます。つまり、2段階で全体をよいモデルに集約させ、計算の効率化を図るわけです」。

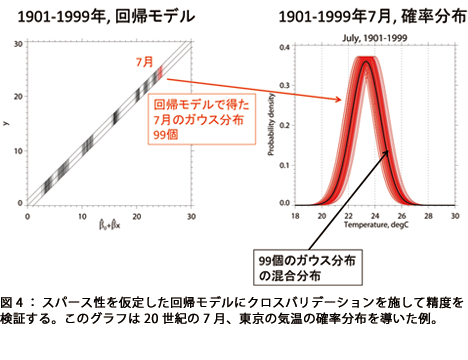

最初のステップでは、クロスバリデーションと呼ぶ手法を用いてモデルの重みづけをする。データセットから1つのサンプルを取り除いてモデルを構築し、このサンプルに対する予測能力でモデルを評価する方法だ。学校の試験にたとえれば、あえて授業では取り上げていない設問を出題して理解度を測る『実力テスト』のようなものだ。

次のステップでは、スパースモデリングというデータ解析法を用いて、予測に有用なモデルを自動的に抽出した(図3)。「統計科学でいま盛んに使われている解析法を気象分野に導入してみたのです」と伊庭。スパースは「疎」の意味。多数のモデルから不要なものを間引いて疎にする手法だ。「先方は初めのうち、『全部計算したら13万年かかります』と危惧されていましたが、この方法では4分で終わりました」と上野は微笑む。

1901年から1999年までの東京の月平均気温データ1188ヵ月分から、1ヵ月ずつデータを除いた1187個のサンプルで検証した(図4)。

将来発生しうる台風の推定に確率的シミュレーションでアプローチ

低頻度事象のほうは、台風が日本に到来する頻度を見積もることをこのプロジェクトでの目標として設定した。「発生した台風が、例えば東京に影響するかどうかは非常に微妙です」と鈴木は説明する。例を挙げれば、2014年10月に関東に上陸した2つの大型台風は、ほぼ同じ軌道をたどりながら、先発の台風18号は東京23区を直撃し、後発の19号は直前で東京を避けて通過。交通機関などの厳戒態勢は肩すかしを食った。

全球気候モデル(GCM)のシミュレーションでも台風に相当するものは発生する。しかし、その個数は年間に30程度で、100年間でも3000に過ぎない。これでは、サンプル数として少なすぎる。そこで考えた手法が、GCMの結果に簡単なモデルをあてはめて、そこから疑似データを発生させることでデータを“水増し”する手法だ。乱数を導入することで、簡単なモデルでも多様な経路を生成することができる。

乱数を用いる台風のモデルは「確率台風モデル」と呼ばれているが、まだ決定版があるわけではない。そこで、統数研チームは2種類の方法で、まず観測値に合うモデル作りから始めている。これができたら、GCMの結果にそれを適用する計画である。

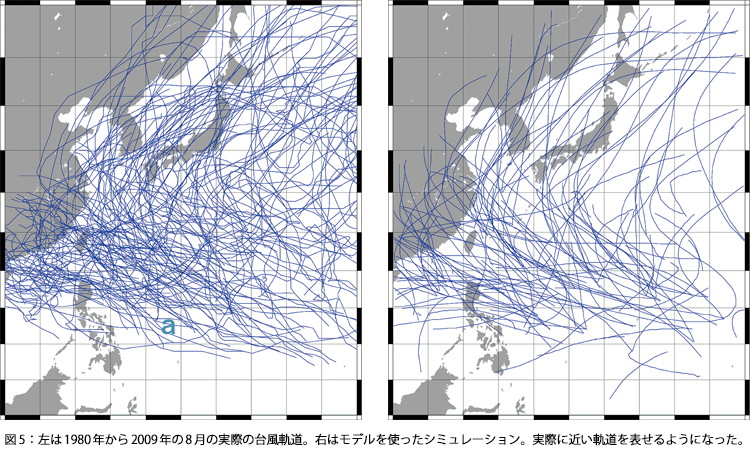

中野は過去60年ほどの気象庁の実測データから台風の移動速度や強度などの確率分布を算出するモデルを構築した。(図5)。「これで、かなり実際に近い台風軌道を表せるようになりました」と中野は話す。

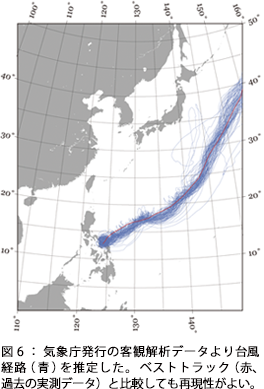

一方、鈴木は台風が周囲の風に流されることに着目し、風速場(風向や風速の変化)から台風の動きを推定する方法を検討している(図6)。「この手法を確立することで、将来の気候状況をより反映した結果が導き出せる可能性があると考えています」と鈴木。

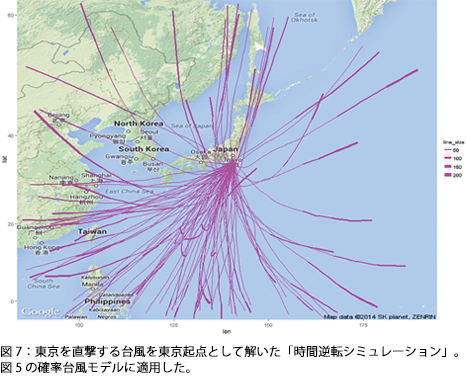

さらに、ユニークな発想で研究を進めているのが伊庭だ。「東京を直撃する台風の経路を予測したいのなら、東京から逆に解いていったらどうか、と考えました」。つまり、ターゲットとなる東京を起点として逆方向のシミュレーションを行う。モデルを単純に逆にすればすむ話ではないが、重みづけなどさまざまな手法を駆使して、正しい確率を求める方法を開発した。伊庭はこれを中野が作成した確率台風モデルに適用して検証を進めている(図7)。

統計科学とのコラボレーションで気象予測の可能性が広がる

気候変動リスク情報創生プログラムは、ほとんどが気象の専門家チームで構成されており、統計分野からは統数研チームが唯一の参加機関だ。上野は「自分たちの知っている方法を提供することで気象分野の人たちの主張の裏付けができ、議論の風通しがよりよくなればと思っています」と話す。

気象研究者との共同研究の計画もある。鈴木は「例えば私たちが東京を直撃する台風の経路を推定できれば、台風のシミュレーションを手掛ける研究者に、風や強度がどうなるか、実験を提案することができます」と期待する。

今後について、伊庭は「個人的にも気象に興味が湧いてきましたので、これからも気象の研究者たちとコミュニケーションを取っていきたいと考えています」と抱負を語る。

気象の予測はインフラの防災対策はもちろん、自治体や産業界のBCP(事業継続計画)にも重要な役割を担う。統計科学や機械学習の手法は、将来的にも気象予測に役立つ側面が多くあるだろう。このプログラムへの参画は、データ同化開発研究センターにとっても貴重な実績を刻むものになる。

(広報室)